Nvidia, il colosso delle GPU che ha conquistato il mondo dell’intelligenza artificiale, non accenna a rallentare la sua corsa. Anzi, con la presentazione della nuova GPU Blackwell B200 e del “superchip” GB200, sembra intenzionata ad allungare ancora di più il passo sulla concorrenza.

Questi mostri di potenza di calcolo, con prestazioni fino a 30 volte superiori rispetto alla già impressionante H100, promettono di ridefinire gli orizzonti dell’AI e di consolidare il dominio di Nvidia in un settore sempre più strategico e competitivo.

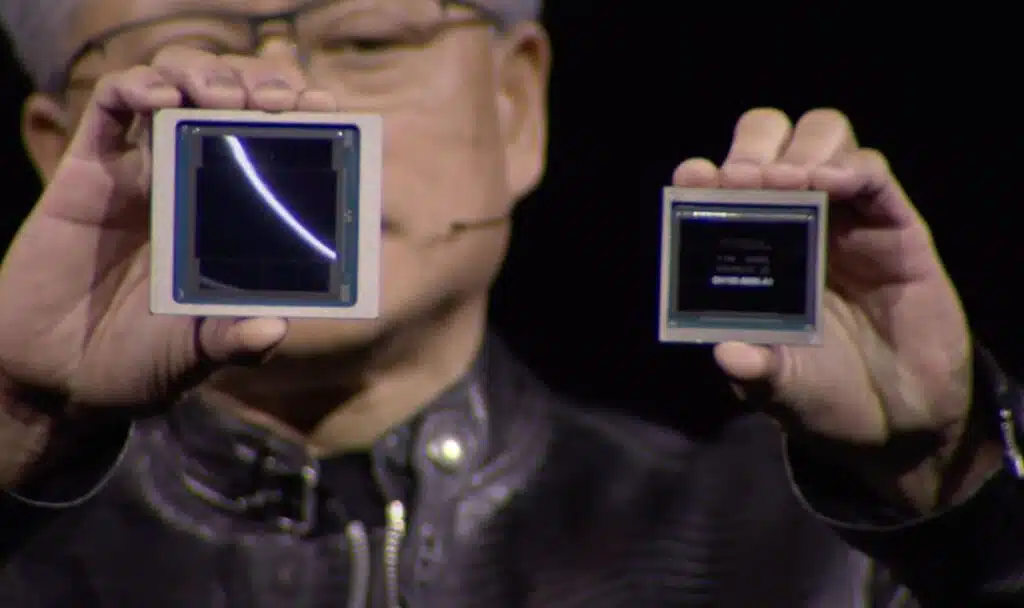

Blackwell B200, 208 miliardi di transistor e 20 petaflops di pura potenza

I numeri fanno girare la testa. La nuova GPU B200 racchiude ben 208 miliardi di transistor (sì, avete letto bene, miliardi) in un singolo chip, sprigionando fino a 20 petaflops di potenza di calcolo in virgola mobile a 4 bit (FP4). Per dare un’idea, si tratta di una potenza paragonabile a quella di 20 milioni di laptop di fascia alta. E tutto questo in un singolo chip grande quanto una cartolina.

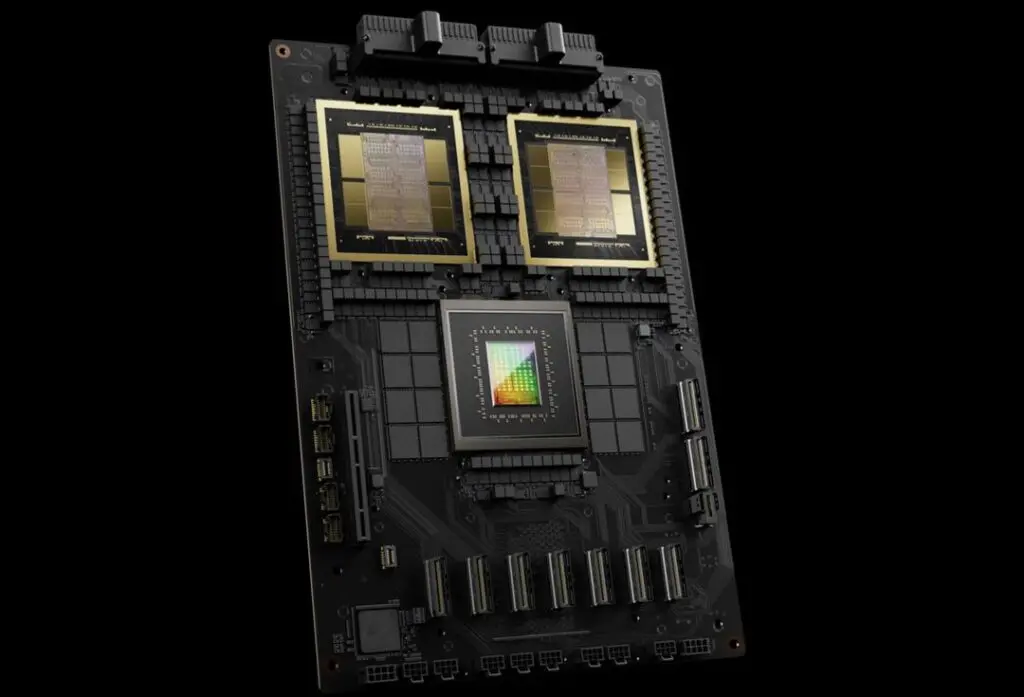

Ma il vero asso nella manica di Nvidia è Blackwell GB200, un “superchip” che fonde due GPU B200 con una CPU Grace in un unico package. Questa bestia da 30 petaflops promette di offrire prestazioni fino a 30 volte superiori rispetto all’H100 nelle attività di inferenza dei grandi modelli linguistici (LLM), con una riduzione dei costi e dei consumi energetici del 25%. In due parole: più potenza, meno spesa, meno impatto ambientale. Si, le parole erano 7.

Quando un chip non basta, ci pensa il “transformer engine”

Come fa Nvidia a tirar fuori tutta questa potenza? Uno dei segreti sta nel “transformer engine” di seconda generazione: un’architettura dedicata che raddoppia la capacità di calcolo, sistemando più neuroni in meno spazio, per reti neurali sempre più grandi e performanti.

Cosa accade quando si mettono insieme decine o centinaia di questi chip in un server? Fino a 576 GPU possono “parlarsi” tra loro con una banda bidirezionale di 1,8 terabyte al secondo. In tre parole (stavolta davvero, giuro): calcolo parallelo estremo.

Dai chip ai supercomputer, il passo è breve

Se volete un’idea di ciò a cui assisteremo tra poco, i sistemi che saranno guidati da questi Blackwell saranno in grado di addestrare modelli con 27 trilioni di parametri. GPT-4 ne vanta “appena” 1,7 trilioni.

Nvidia sembra lanciare una sfida a tutto il mondo dell’AI: volete andare veloci? Seguiteci. E i big del cloud sembrano aver colto il messaggio al volo: Amazon, Google, Microsoft e Oracle si sono già messi in fila per offrire questi gingilli nei loro servizi. Segno che la fame di potenza di calcolo è più forte che mai.

Con i Blackwell, Nvidia uccide il mercato?

C’è chi storce il naso di fronte a questo strapotere di Nvidia, che rischia di creare un monopolio de facto in un settore chiave come l’intelligenza artificiale. Fa bene a porsi la questione. C’è chi teme che questa corsa al “più grande, più veloce, più potente” possa portare a uno sviluppo incontrollato di sistemi di AI sempre più complessi e imprevedibili. Anche questa è una domanda legittima.

Perché oltre questi punti interrogativi, con Blackwell e GB200 Nvidia ha dimostrato di avere il piede schiacciato sull’acceleratore dell’innovazione. Di brutto. E di non aver nessuna intenzione di toglierlo.

Che piaccia o no, il futuro dell’AI parla sempre più il linguaggio delle GPU. E ha il volto sornione di Jensen Huang.

FONTE: https://www.futuroprossimo.it/2024/03/nvidia-lancia-blackwell-b200-il-chip-piu-potente-al-mondo/

Commenti

Posta un commento

Partecipa alla discussione